Rekonesans w sieci #103 🧪️ 📝️ Witaj w świecie syntetycznych treści

Masz ochotę wypisać się z newslettera jeśli wątpisz, czy pisał go człowiek, czy AI? Ja też. Niestety zapowiada się, że syntetyczne treści mogą nas zalać, oczywiści z pomocą BigTechu...

Media społecznościowe bez społeczności, za to pełne treści z AI

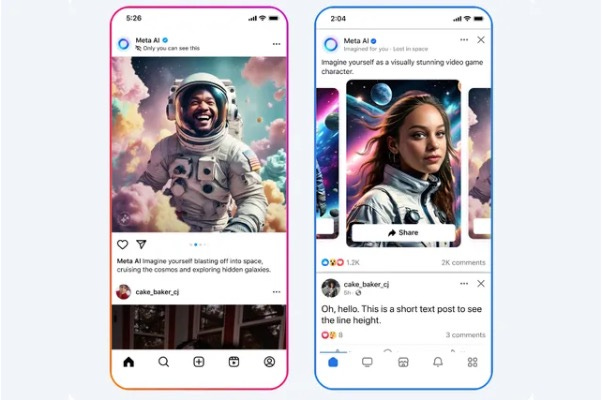

Algorytmy w mediach społecznościowych serwują nam treści tak, by przyciągały naszą uwagę jak najdłużej. Serwują coraz więcej treści polaryzujących, wywołujących gniew, strach lub szok. Co może być jeszcze lepsze w takie przejmowanie naszej uwagi? Dodanie do algorytmów treści generowanych przez AI, najlepiej z naszymi twarzami!

Przykład spersonalizowanych treści generowanych w feed Facebooka, prezentacja Meta.

Meta wprowadza treści generowane przez AI, które są tworzone na podstawie naszych wieloletnich zachowań w sieci. Dziennikarz i autor newsletter Platformer, Casey Newton przewiduje, że w ciągu kilku lat większość treści w mediach społecznościowych będzie tworzona przez AI. Wraz z rosnącym wpływem big techu, zaufanie do sieci będzie spadać. Kiedy do cyberprzestępców i spamerów, którzy już teraz zalewają serwisy społecznościowe absurdalnymi treściami generowanymi z AI, dołączą firmy big tech, nie będzie już odwrotu od braku zaufania w sieci.

Większość dyskusji o zagrożeniach dezinformacją AI skupia się na cyberprzestępczości, oszustach i wprowadzaniu w błąd w celach politycznych. Treści generatywne są również wykorzystywane bardziej oficjalnie.

Treści generowane na temat prawdziwych wydarzeń lub o nas (Meta, jak opisane wyżej)

Wykorzystywanie generatywne w artykułach prasowych zamiast autorów/ek (na razie częściej po cichu niż publicznie, ponieważ czytelnicy/czki ufają takim treściom mniej i nie chcą za nie płacić)

Zastępowanie ludzi botami i awatarami w obsłudze klienta zmienia charakter interakcji. Ogranicza je do sztywno zaprogramowanych odpowiedzi, co utrudnia spontaniczne rozmowy.

Powszechne używanie generatywnej AI w reklamach, w tym zastępowanie modeli i modelek.

Pomijając na chwilę kwestie wpływu na rynek pracy (grafików, modeli) to powszechność postaci wygenerowanych z pomocą AI w reklamach, błyskawicznie przyzwyczaja nas do tego, że mamy do czynienia z syntetycznymi treściami na każdym kroku.

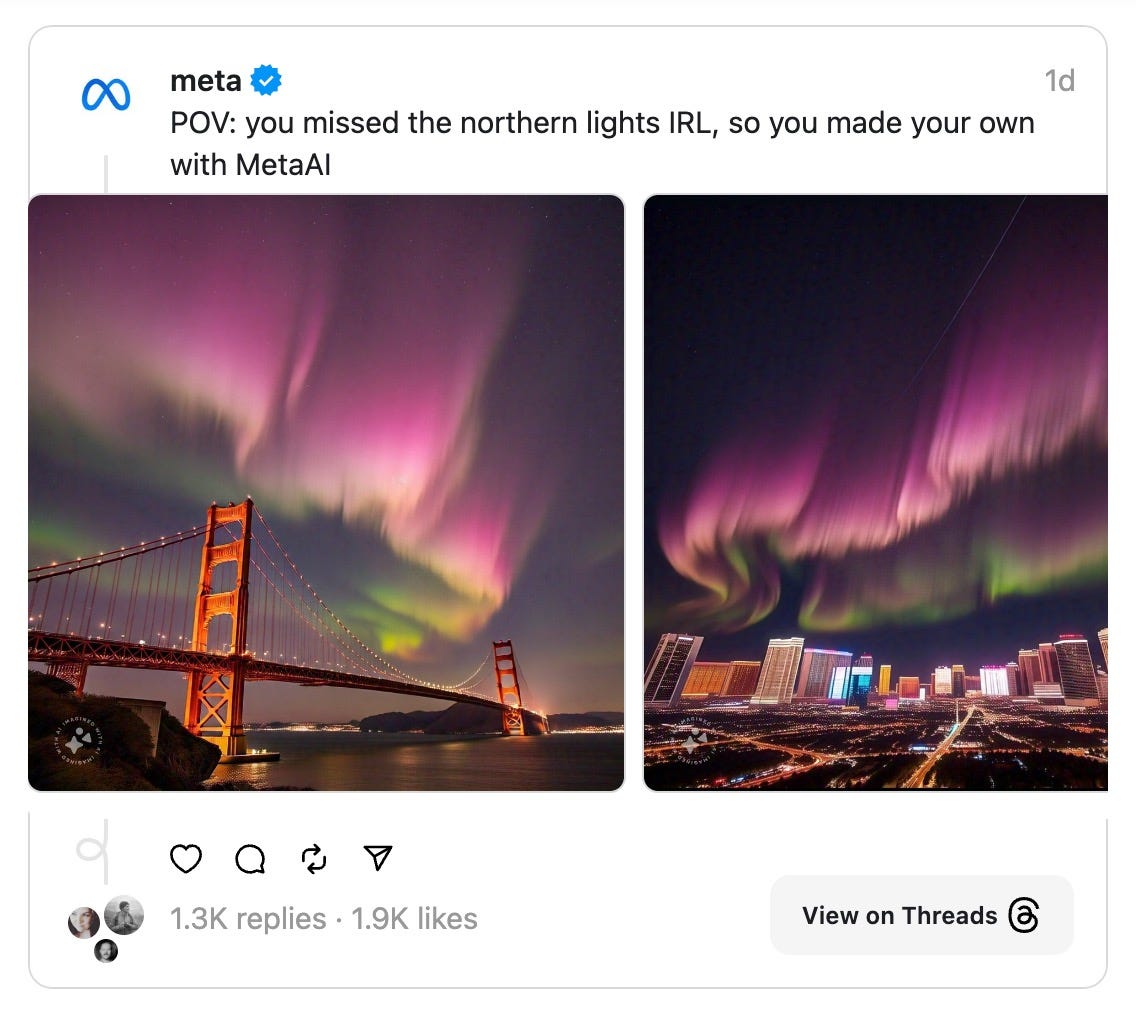

Wygenerowane z pomocą AI zdjęcia zorzy polarnej nad San Francisco, które opublikowało oficjalne konto Meta, oburzyło wiele osób, które w serwisach firmy publikowały prawdziwe zdjęcia.

Na co zwraca uwagę wiele dziennikarek i dziennikarzy oraz badaczy dezinformacji: większym zagrożeniem niż to, że ludzie będą nabierać się na wyrafinowane nieprawdziwe treści — ale to, że zupełnie przestanie obchodzić ich, co jest prawdą, a co fałszem. Można nazywać to nihilizmem wobec informacji, albo wiarą nie w prawdę, a w to, co czujemy, że jest prawdą (czyli co jest zgodne z moimi chęciami, emocjami). W takim stanie wydają się być już co najmniej USA, które przed chwilą przeszły dwa huragany, a wśród dezinformacji pojawią się m.in. obrazy uderzające wprost w służby niosące pomoc. Politycy, którzy je rozpowszechniają, nie ukrywają swojej świadomości, że są to deep-fake, ponieważ nie chodzi im o fakty, a wzmacnianie negatywnych emocji i wątpliwości w działania agencji rządowych.

Zanim doczekamy się powszechnej i dobrze działającej regulacji, która wymusi oznaczanie treści generowanych z pomocą AI, powinniśmy zastanowić się również nad tym co zrobić z efektami emocjonalnymi konsumpcji wygenerowanych, nieprzedstawiających faktów treści.

Wiele badań opisuje jak, poleganie na emocjach z jednej strony zwiększa szanse na to, że staniemy się ofiarami dezinformacji (uwierzymy w nieprawdę). Z drugiej zaś strony kompetencje do rozpoznawania własnych emocji, zmniejszanie reaktywności i ćwiczenie uważności może nam pomóc w detekcji dezinformacji. Co ciekawe, modele AI można również uczyć metod rozpoznawania dezinformacji na podstawie detekcji emocji w treściach, które analizują. Co jednak zrobić z dezinformacją, o której odbiorcy wiedzą, że jest nieprawdą, ale przyjmują w nią wierzyć, bo odpowiada ich emocjom?

Nikt nie chce czytać newsów generowanych przez AI, ale niebawem możemy nie mieć wyboru

Open AI, podobnie jak wcześniej Google, jedną ręką (i swoim modelem biznesowym) niszczy media, a drugą znacznie mniej hojną, chętnie chwali się ich wspieraniem. Sytuacja firmy stojącej za ChatGPT jest jednak odrobinę gorsza od Google. OpenAI płaceniem mediom próbuje złagodzić relację z nimi, zanim sądy w USA będą decydować co zrobić pozwami topowych gazet, w tym The New York Times, o naruszenie ich prawa autorskich przez naukę modeli na bazie dostępnych za paywallami treści. Jak przyznał ostatnio podczas konferencji szef openAI ds. partnerstw medialnych Varun Shetty, “nikt nie chce czytać wiadomości generowanych przez AI”. Firma stawia sobie za cel rozwój narzędzi wspierających media i próbuje przekonywać, że współpraca z chatbotami będzie oznaczać ruch na strony wydawców. Tylko że sami nie brzmią do tego zbyt przekonani. Jak pokazuje przykład Google News i zasysanych przez wyszukiwarkę fragmentów newsów, które miały przynieść więcej odwiedzin mediom, stało się odwrotnie.

Bot na teorie spiskowe

Syntetyczne treści i interakcje z botami, zamiast ludzi mogą być wykorzystywane w wielu celach. Badacze i badaczki z Massachusetts Institute of Technology, Cornell i American University postanowili sprawdzić, czy chatbot może być skutecznym narzędziem odciągania ludzi od teorii spiskowych? „debunkbot” przedstawia spokojnie szczegółowe kontrargumenty i spróbować zmienić ich zdanie. Według wstępnych badań rozmowy z chatbotem zmniejszyły ogólne zaufanie uczestników do ich rzekomej teorii spiskowej o średnio 20%. Około jedna czwarta uczestników całkowicie odrzuciła swoją teorię spiskową po rozmowie z AI. Badacze przyznają, że chatboty nie są idealnym narzędziem do tego zadania, ale mogą pomóc np. w moderacji forów i uczestniczyć w dyskusjach, aby zmniejszyć szanse rozpowszechniania się teorii spiskowych.

Canva podrożeje nawet o 300%... bo AI

Na pierwszy ogień idą konta zespołowe, głównie wykorzystywane w biznesie (Canva Teams) w USA. Najpopularniejszy edytor grafik w sieci będzie podnosić ceny, ponieważ dodał wiele funkcji opartych o sztuczną inteligencję, a te kosztują (zwłaszcza za sprzęt do treningu modeli AI i energię). Firma, aby móc ścigać się z błyskawicznie rosnącymi w popularność generatorami grafik AI, kupiła serwis Leonardo.ai, który oferuje znacznie lepszą jakość (i kontrolę nad wynikami) niż własne generatory Canvy. Na razie nie zapowiada się, aby podwyżki dotknęły darmowych kont dla organizacji pozarządowych i edukacji.

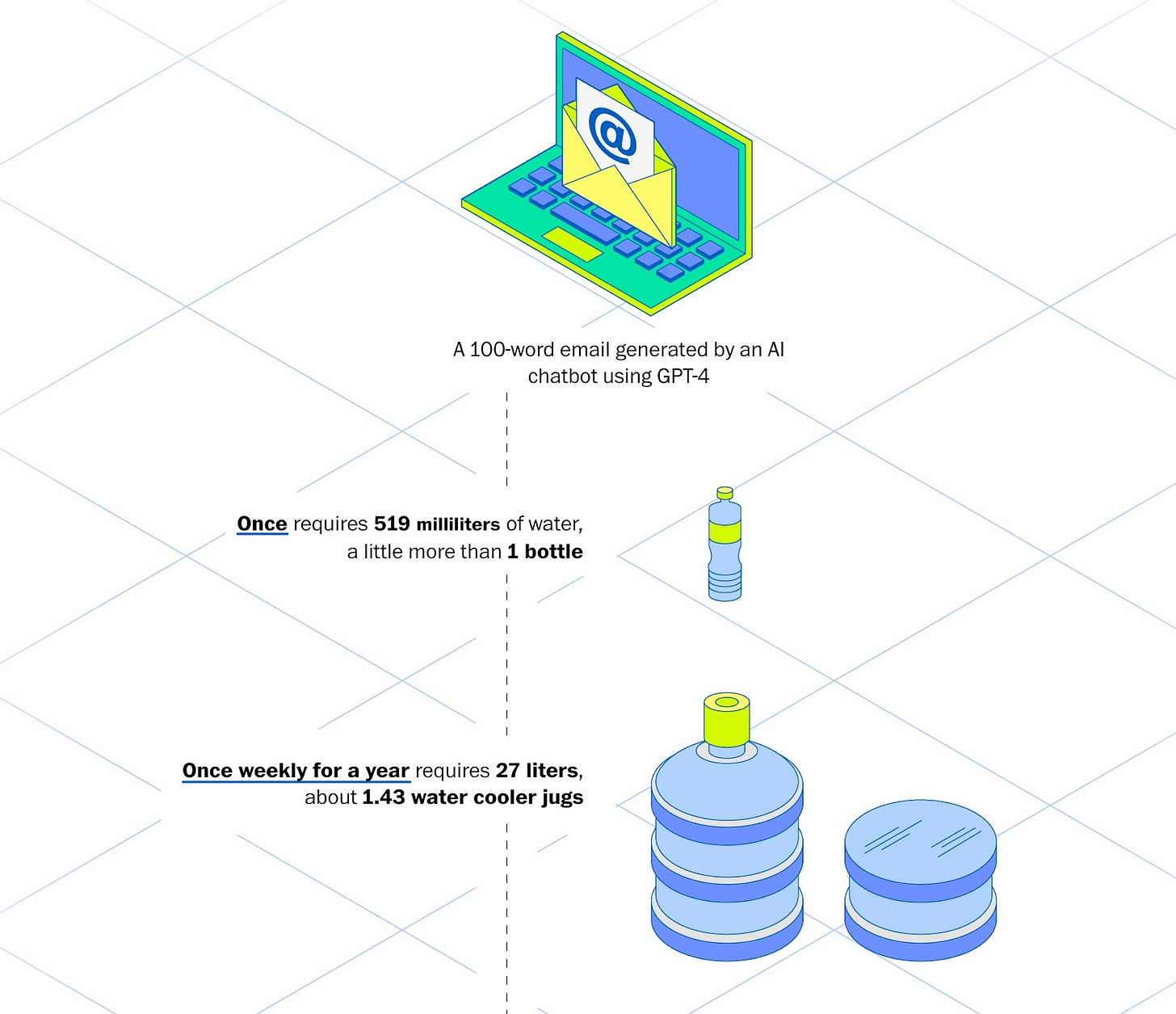

Jeśli jakieś narzędzia generatywnej AI pozostają jeszcze darmowe lub mają takie wersje kont, to dlatego, że są jeszcze w fazie wzrostu i wydają pieniądze od inwestorów aby pozyskać jak najwięcej użytkowniczek i użytkowników. Nie są to jednak tanie usługi (tutaj kalkulacje McKinsey, budowy i uczenia własnego modelu oraz jego działania). Poza treningiem i wynagrodzenie specjalistów, działanie modeli AI zużywa ogromną ilość energii (a przy okazji wody) po stronie centrów danych. Pisałem o tym w kilku poprzednich odcinkach, teraz podrzucę tylko jedną z nowszych liczb na ten temat. Wg. szacunków Washington Post, mail o długości 100 słów wygenerowany przez chatbota AI przy użyciu GPT-4 wymaga 0,14 kilowatogodzin (kWh) energii elektrycznej, co odpowiada zasilaniu 14 żarówek LED przez 1 godzinę oraz 519 mililitrów wody (odrobinę więcej niż półlitrowa butelka).

Czy osoby korzystające z Canvy potrzebują usług AI? Czy może Canva potrzebuje AI, aby uzasadnić wzrost cen użytkownikom? Bez danych o tym czy są to popularne funkcje, ciężko odpowiedzieć na to pytanie. W obu przypadkach koszty energetyczne i środowiskowe powinny dla firmy, która chce być odpowiedzialna społecznie, powinny jednak powstrzymać ją przed tak szybkim wdrażaniem nowych funkcji. W tym momencie prawie nikt na rynku usług AI nie próbuje prowadzić bardziej zrównoważonego rozwoju usług, w którym pojawiałyby się one na masową skalę dopiero po zbadaniu ich kosztów środowiskowych i znalezieniu sposobów na ich ograniczenie.

Podkasty bez ludzkich prowadzących i AI w bibliotekach

Prowadziłem ostatnio warsztaty o sztucznej inteligencji dla bibliotekarek i bibliotekarzy z Wojewódzkiej i Miejskiej Biblioteki w Gdańsku. Eksperymentowaliśmy, jak narzędzia AI mogą wpłynąć na ich pracę i na praktyki czytelnicze. Dwa narzędzia wzbudziły największe emocje:

NotebookLM, który analizuje jednocześnie do 50 dokumentów i może generować podkast na temat zawartych w nich informacji.

ElevenLabs, które czyta audiobooki w kilkudziesięciu językach (łącznie z ePub i ze zdjęć).

Dyskutowaliśmy o tym jak AI może zmieniać to jak ludzie będą konsumować treści w niedalekiej przyszłości lub jak się mogą przez to podzielić na czytających tradycyjnie i korzystających głównie z AI (podsumowującej treści, czytającej jak lektor itp.). Wobec popularności AI warto zastanowić się nie tylko nad rolą bibliotek jako centrów transferu wiedzy i kompetencji cyfrowych. Niekoniecznie muszą być one pełne narzędzi AI, ale na pewno przyda im się wsparcie w tym jak radzić sobie ze zmianami praktyk odbiorców.

Niepokoi mnie też coś, co usłyszałem już od kilku bibliotekarek podczas różnych okazji warsztatowych, że powinny robić mniej działań animacyjnych i edukacyjnych, a skupić się na tradycyjnej roli bibliotek, czyli wypożyczaniu i promocji czytelnictwa (klasyczne spotkania z autorami itp.). Nie wiem, czy to większy trend, ale osobiście wierzę, że sukces bibliotek to ich elastyczność i wieloznaczność jako miejsca spotkań, edukacji, inkluzywności, wymiany wiedzy, nie tylko z książek.

Gdzie możemy się spotkać?

Forum Fundacji Orange 24.10 gdzie będę prowadzić warsztaty o odpowiedzialnym i bezpiecznym korzystaniu z AI w działaniach edukacyjnych.

IX Forum Edukacji Dorosłych, 20-21.11 w Warszawie i online, gdzie będę opowiadać o zagrożeniach AI z perspektywy prawa autorskiego i bezpieczeństwa danych.

Sytuację z mema ze Spidermanem zapewnił mi ostatnio Copilot. Dziękuję za newsletter, jak zawsze w punkt i współgra z moimi przemyśleniami.