Rekonesans w sieci #102

Życie z internetem to konieczność codziennego wyrażania sprzeciwu, zwłaszcza wobec zawłaszczania naszych danych i komercjalizowania wszystkiego na siłę.

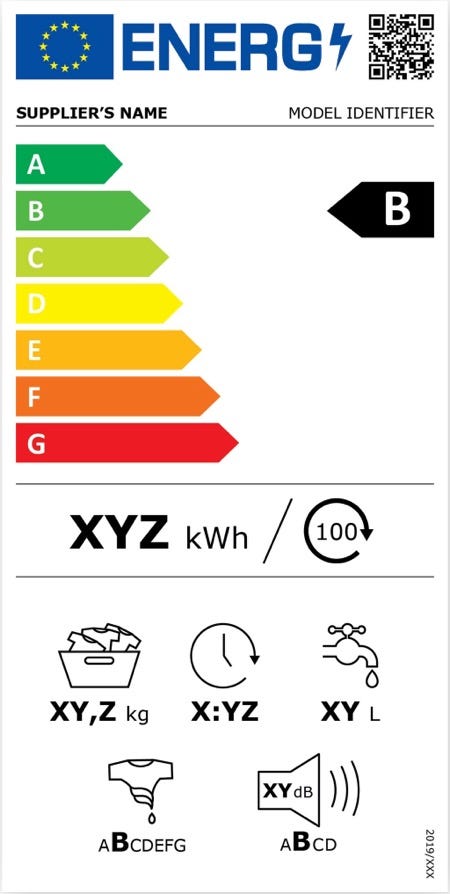

Narzędzia cyfrowe powinny być opisywane jak produkty spożywcze i AGD

Pomysł jest prosty:

Podobnie jak sprzęt typu żarówki czy lodówki, aplikacje, serwisy streamingowe, czatboty AI, wyszukiwarki powinny publikować łatwo dostępne informacje o zużywaniu przez siebie energii.” Proponuję: „Podobnie jak żarówki czy lodówki, aplikacje, serwisy streamingowe, czatboty AI i wyszukiwarki powinny podawać informacje o zużyciu energii.

Narzędzia wykorzystujące sztuczną inteligencję (czyli algorytmy uczenia maszynowego) powinny informować precyzyjnie, o tym, jakiego rodzaju algorytmy wykorzystują, na jakich danych były trenowane, w jaki sposób uzyskały zgodną z prawem zgodę na takie wykorzystanie.

Czy to trudne zadanie? Z pewnością, ale nie jest niemożliwe (co pokazuje bardzo dobry przykład Hugging Face). Informacje te nie są oczywiście wygodne dla twórców aplikacji i narzędzi AI. Mierzenie jest wymagające, a same informacje mogą negatywnie wpłynąć na ich wizerunek. Jendak dokładnie o to chodzi w zdrowym rynku technologii. Dzięki tym informacjom użytkownicy mogliby podejmować bardziej świadome decyzje, w tym rezygnację z niektórych usług. Tempo rozwoju tych technologii mogłoby zostać spowolnione, a większy nacisk moglibyśmy położyć nie na nowe funkcje, a na optymalizację bezpieczeństwa czy kosztów środowiskowych.

Wielu osób w polityce i mediach od ponad roku powtarza argument za regulacją AI, że nie możemy pozwolić sobie na powtórkę z mediami społecznościowymi i brakiem ich opanowania przez prawo większości państw. Do dziś badacze i badaczki mają ograniczony dostęp do danych dot. bezpieczeństwa dzieci w największych platformach, fact-checkerzy zdani są na łaskę platform, w kwestii współpracy nad śledzeniem i zwalczaniem dezinformacji. Niezbędny jest nowy paradygmat rozwoju technologii, od tego, który narzuciła dolina krzemowa i toksyczna mieszanka start-upów i firm w nie inwestujących. W jego ramach potrzebujemy nie tylko dostępu do informacji, ale również stosowania prostego języka i poświęcenia sporej uwagi na wyjaśnianie działania technologii w sposób zrozumiały i użyteczny dla wszystkich, od dzieci po decydentów, niezależnie od ich kompetencji technologicznych. Wiedza o technologiach, zwłaszcza o AI, nie powinna być zmonopolizowana przez ich twórców. Edukacja o technologiach powinna zaś być konstruowana również po to, by zapewniać wszystkim możliwość lepszego decydowania o jej wpływie na ich życie. W tym momencie zaś znów w mojej opinii za bardzo skupiamy się na edukacji, zwłaszcza o AI, z perspektywy kompetencji zawodowych (o czym pisałem w poprzednim odcinku o Programie Transformacji Cyfrowej Edukacji).

Osobom, które uważają, że niemożliwy jest rozwój technologii przy takich ograniczeniach, można tylko przypomnieć, że:

po pierwsze, technologie świetnie rozwijają się na całym świecie, w różnych systemach regulacyjnych, o różnych wartościach (np. takich jak silna ochrona praw pracowników czy bezpieczeństwa i prywatności),

mierzenie wszystkiego miarą sukcesów firm amerykańskich to przyznanie się do tego, że jedyną miarą sukcesu jest wzrost i wycena przez inwestorów (nie zawsze nawet związany z faktyczną wartości czy zyskami firm), a zupełne pomijanie wartości ludzkich (bezpieczeństwo, wolność, prywatność, spójność społeczna),

u podstaw mnóstwa technologii o najwyższej faktycznej przydatności społecznej (komputer, internet, cyfrowe mapy, nawigacja GPS, łączność bezprzewodowa) leży ogromne wsparcie rządowe dla firm i akademii, które biznes uwielbia pomijać (zainteresowanym polecam świetną książkę ekonomistki Marianny Mazucatto Przedsiębiorcze państwo. Obalić mit o relacji sektora publicznego i prywatnego… ze wstępem byłego premiera Mateusza Morawieckiego, serio).

AI Act wprowadzi obowiązek podawania przez narzędzia wysokiego AI (związane m.in. z ochroną zdrowia, prawem, edukacją, procesami rekrutacji), części z tych informacji, ale musimy na to poczekać do 2026 roku, na pełne wdrożenie tych przepisów. Niestety zapisy te zostały mocno zmiękczone do poziomu “stosowania standardów i dobrych praktyk w obszarze wykorzystania energii”.

LinkedIn też chce uczyć AI na Twoich danych… powstrzymuje go tylko RODO, Meta bierze wszystko jak leci, co opublikowaliśmy od 2007 roku…

Zanim wejdzie w życie AI Act, na straży naszych danych (czasami) stoi RODO, czyli unijna regulacja ochrony danych osobowych. Niedawno LinkedIn przyznał się, że bez informowania czy dodatkowego pozyskiwania zgody, szkoli swoje modele sztucznej inteligencji na danych użytkowników i użytkowniczek. Wyjątek stanowią państwa UE i Szwajcaria, w których obowiązują znacznie silniejsze przepisy ochrony. LinkedIn musiałby uzyskać w nich dodatkową zgodę na takie wykorzystanie danych. Jeśli korzystasz z LinkedIn poza Unią Europejską możesz odmówić zgody TUTAJ.

Meta/Facebook do nauki swoich modeli AI korzysta ze wszystkiego, co użytkownicy i użytkownicy umieścili w serwisie jako publicznie od 2007 roku. Meta będzie respektować nasze prawo do odmowy, ale tylko jeśli je wyrazimy. Jeśli masz konto na Facebooku, możesz od razu przejść do formularza sprzeciwu TUTAJ. Na głównej stronie ustawień prywatności znajdziesz również informacje o zmianach w polityce prywatności, którą firma zmieniła w czerwcu tego roku, z obietnicą, że zostaniemy poinformowani, kiedy nasze dane zostaną wykorzystane…

Google i Meta hakują nawet własne regulacje byle nadal móc sprzedawać targetowanie reklam dla dzieci

Wbrew przepisom, obietnicom i własnym wewnętrznym politykom obie firmy dawały opcje agencjom reklamowym do profilowania reklam dla osób niepełnoletnich nawet wtedy, kiedy teoretycznie nie powinny mieć o nich danych. Wystarczyło opisać grupy jako “nieznane”, ale nadal korzystać z danych, które pozwalały na określanie z dużym prawdopobieństwem, że są to ludzie w wieku 13-18 lat. Wg. śledztwa Financial Times, firmy chwaliły się tymi alternatywnymi rozwiązaniami przed potencjalnymi reklamodawcami, nazywając to hackowanie własnych ograniczeń. Ponoć to rozwiązanie zostało już wewnętrznie anulowane, ale nie wiem, czy ktokolwiek jeszcze ufa, że firmy te nie będą próbować wszystkiego, co w ich mocy, by obchodzić przepisy. Zwłaszcza wtedy kiedy konkurują z innymi serwisami, jak TikTok.

Kilka dni temu odbywała się konferencja programu Safer Internet, który ma ogromne zasługi w dziedzinie edukacji o bezpieczeństwie dzieci w sieci. Bardzo ucieszyłem się, widząc, że w tym roku nie korzysta ona już z partnerstw i sponsoringu firm big tech jak Google i Meta. Firmy te po prostu nie przestają same dowozić argumentów, za tym, że powinno trzymać się je z daleka od dzieci i nie promować ich wizerunku jako odpowiedzialnych. Mam nadzieję, że firmy te wypadną również z agendy Dnia Bezpiecznego Internetu w 2025, a organizacje zajmujące się bezpieczeństwem i edukacją dzieci będą wymagać więcej od swoich partnerów.

Aplikacja, która testuję

STORM (Structured Task-Oriented Research Machine) - model AI z uniwersytetu Stanforda, który generuje oparte o źródła dokładne artykuły na na dane zagadnienie. Jeśli korzystasz z narzędzi typu Perplexity, które łączą generatywne AI z wyszukiwaniem, STORM to ich wersja turbo naukowa. Tutaj możesz przeczytać więcej czym różni się to narzędzie od popularnych chatbotów AI.

Książka, którą polecam

Cześć pracy. O kulturze zapierdolu. Zofia Smełka-Leszczyńska. Tytuł mówi sam za siebie. To lektura nie tylko o tym, dlaczego pracujemy dużo, ale też jak wiele w kulturze i języku ma nas do tego zachęcać, sprawiać, że czujemy się winne_i za nie pracowanie, za nie bycie wystarczająco efektywni.